A inteligência artificial (IA) está transformando o mundo em um ritmo vertiginoso, trazendo inovações que vão desde assistentes virtuais até ferramentas de programação avançadas. No entanto, junto com os benefícios, surgem desafios éticos e legais que expõem o lado sombrio dessa tecnologia. Um caso recente em Almería, na Espanha, divulgado em 5 de maio de 2025, trouxe à tona as implicações preocupantes do uso indevido da IA: um homem foi condenado a mais de cinco anos de prisão por distribuir pornografia infantil gerada por inteligência artificial, utilizando imagens de familiares e vizinhos. Este caso, reportado pela Infobae, não é apenas um marco jurídico, mas também um alerta sobre os limites éticos da IA e a necessidade de regulamentações mais robustas. No EditorTech, exploramos como esse incidente reflete os desafios legais emergentes e o que ele significa para o futuro da tecnologia.

- Opção de sistema de áudio multi-room. | Conexão Wi-Fi e Bluetooth.

O Caso de Almería: Um Precedente Legal

Em Almería, a justiça espanhola condenou um indivíduo a 5 anos e 9 meses de prisão por criar e distribuir material pedófilo gerado por IA. O condenado manipulava fotos de pessoas próximas, como familiares e vizinhos, para produzir conteúdo explícito, que era compartilhado em redes sociais. Além da pena de prisão, ele perdeu a autoridade parental e foi obrigado a realizar cursos de formação sobre delitos sexuais, uma medida que destaca a gravidade do crime. Este caso, detalhado em um artigo da Infobae, é um dos primeiros a abordar diretamente o uso de IA na geração de conteúdo ilegal, levantando questões sobre como as leis atuais podem lidar com tecnologias emergentes.

A criação de imagens por IA, especialmente com ferramentas generativas como deepfakes, tornou-se acessível a qualquer pessoa com conhecimentos básicos de tecnologia. Essas ferramentas, originalmente desenvolvidas para fins criativos ou de entretenimento, podem ser facilmente desviadas para propósitos maliciosos. No caso de Almería, o uso de fotos reais para gerar conteúdo fictício, mas visualmente convincente, expôs vítimas a danos emocionais e sociais significativos. Este incidente sublinha a necessidade de distinguir entre o uso legítimo e o abuso da IA, especialmente em contextos que envolvem privacidade e dignidade humana.

Desafíos Legais e Éticos

O caso de Almería destaca vários desafios legais que acompanham o avanço da IA. Primeiro, há a questão da autoria: quem é responsável pelo conteúdo gerado por IA? O usuário que fornece os dados iniciais ou a empresa que desenvolveu a ferramenta? No caso espanhol, o usuário foi diretamente responsabilizado, mas isso nem sempre é tão claro. Ferramentas de IA generativa, como DALL-E ou Stable Diffusion, operam com base em modelos treinados em vastos conjuntos de dados, muitas vezes sem supervisão direta sobre como são usadas. Isso levanta questões sobre a responsabilidade das empresas de tecnologia em monitorar ou restringir o uso de suas criações.

Além disso, as leis atuais, em muitos países, não estão preparadas para lidar com crimes envolvendo IA. A legislação sobre pornografia infantil, por exemplo, tradicionalmente foca em conteúdo envolvendo vítimas reais. No caso de imagens geradas por IA, não há uma vítima física direta, mas o impacto psicológico e social permanece significativo. Isso cria um vácuo legal: como punir a criação de conteúdo que, embora artificial, causa danos reais? A decisão em Almería estabelece um precedente, mas também expõe a necessidade de atualizar os códigos penais para abordar essas nuances.

Do ponto de vista ético, o caso levanta questões sobre privacidade e consentimento. As vítimas, cujas imagens foram manipuladas, não tinham conhecimento ou controle sobre o uso de suas fotos. Isso reflete um problema maior com a IA: a facilidade com que dados pessoais podem ser explorados sem permissão. A ética digital exige que os desenvolvedores de IA implementem salvaguardas, como restrições de uso ou detecção de conteúdo ilícito, mas essas medidas ainda estão em estágios iniciais.

Outros Casos e Tendências Globais

O caso de Almería não é isolado. Em todo o mundo, o uso indevido da IA está gerando preocupações legais. Um exemplo recente, também reportado pela Infobae em 6 de maio de 2025, envolve a clonação de voz por IA para realizar estafas virtuais. Criminosos utilizam amostras de áudio para replicar vozes de pessoas próximas às vítimas, enganando-as em fraudes financeiras. Esses casos mostram como a IA pode ser uma ferramenta de dupla face, capaz de inovar, mas também de facilitar crimes sofisticados.

Outro exemplo preocupante é o uso de deepfakes em campanhas de desinformação. Durante eleições recentes em vários países, vídeos falsos gerados por IA foram usados para manipular a opinião pública, criando narrativas enganosas sobre candidatos. Esses incidentes reforçam a necessidade de tecnologias de detecção de deepfakes e regulamentações que penalizem sua disseminação maliciosa.

O Papel das Empresas e da Sociedade

As empresas de tecnologia têm um papel crucial na mitigação dos riscos associados à IA. Gigantes como Google, Meta e OpenAI estão investindo em ferramentas para detectar conteúdo gerado por IA, mas o progresso é lento. Por exemplo, em um julgamento antimonopolista recente, foi revelado que o Google continua treinando sua IA com conteúdo web, mesmo quando editores optam por não participar, levantando questões sobre o uso ético de dados. Essas práticas sugerem que o lucro muitas vezes supera as preocupações éticas, o que exige maior pressão regulatória.

A sociedade também deve desempenhar um papel ativo. A educação digital é essencial para que os usuários compreendam os riscos da IA e saibam como proteger seus dados. Além disso, os governos precisam colaborar internacionalmente para criar padrões globais de regulamentação. A União Europeia, com sua Lei de Inteligência Artificial, está liderando o caminho, mas outros países precisam seguir o exemplo para evitar lacunas legais que permitam abusos.

O Futuro da IA e a Necessidade de Equilíbrio

O caso de Almería é um lembrete de que a IA, embora poderosa, não é neutra. Ela reflete as intenções de quem a utiliza, seja para o bem ou para o mal. À medida que a tecnologia avança, é crucial encontrar um equilíbrio entre inovação e responsabilidade. Isso significa investir em regulamentações que protejam os indivíduos sem sufocar o potencial criativo da IA.

No EditorTech, acreditamos que o futuro da IA depende de uma abordagem colaborativa. Desenvolvedores, legisladores e a sociedade civil devem trabalhar juntos para garantir que a tecnologia seja usada de forma ética e segura. Casos como o de Almería servem como um alerta, mas também como uma oportunidade para aprender e evoluir. A IA pode transformar o mundo para melhor, mas apenas se enfrentarmos seus desafios com coragem e responsabilidade.

Conclusão

O caso de Almería marca um momento crítico na interseção entre IA, ética e lei. A condenação por pornografia infantil gerada por IA expõe os perigos de uma tecnologia poderosa quando mal utilizada, ao mesmo tempo em que destaca a urgência de regulamentações atualizadas e práticas éticas robustas. No EditorTech, continuaremos acompanhando esses desenvolvimentos, trazendo análises detalhadas sobre como a IA está moldando nosso futuro. A pergunta que остается é: como garantiremos que a IA sirva à humanidade sem comprometer nossa segurança e dignidade?

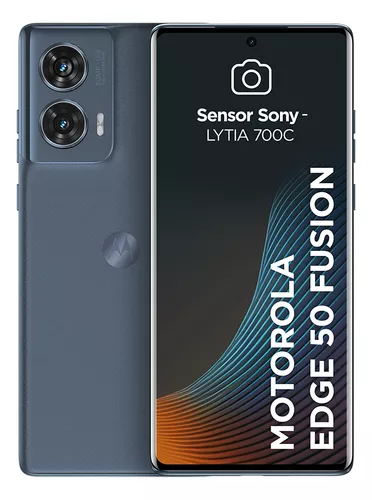

Promoção Relâmpago de Smartphones no Mercado Livre!

Ei, você, apaixonado por tecnologia! Preparado pra dar um upgrade no seu celular e brilhar nas selfies? Logo abaixo, tá nossa tabela turbinada com os melhores smartphones do Mercado Livre, com preços que vão fazer seu bolso sorrir! Corra pra garantir o seu favorito antes que voem mais rápido que um stories no feriado!

É só clicar e escolher no Mercado Livre, mas não pisca, porque essas ofertas são por tempo limitado até 10/05/2025!